ABSTRACT

Retrieval-augmented language models(탐색 증강 언어 모델)은 세계 상태의 변화에 더 잘 적응하고, 다양한 지식을 통합할 수 있습니다. 하지만 대부분의 기존 방법은 탐색할 때 단편적인 짧은 텍스트 조각들만 사용하여 문서 전체의 맥락을 이해하는 데 한계가 있습니다.

우리는 새로운 접근 방식을 소개합니다. 이 방법은 텍스트 조각들을 반복적으로 임베딩(embedding), 군집화(clustering), 요약하여, 아래에서 위로 요약 수준이 다른 트리를 구성합니다. 추론 시점에는 RAPTOR 모델이 이 트리에서 탐색하여, 긴 문서의 정보를 다양한 추상화 수준에서 통합합니다.

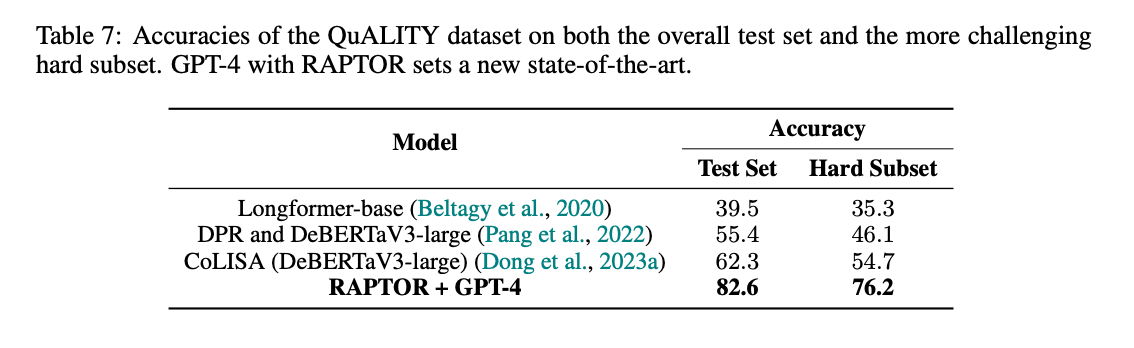

실험 결과, 반복적인 요약을 통한 탐색은 전통적인 탐색 증강 언어 모델보다 여러 작업에서 유의미한 성능 향상을 보였습니다. 특히 복잡하고 다단계의 추론이 필요한 질문-답변 작업에서 최첨단 성과를 달성했습니다. 예를 들어, RAPTOR 탐색과 GPT-4를 함께 사용하면 QuALITY 벤치마크에서 절대 정확도를 20% 향상시킬 수 있었습니다.

1 INTRODUCTION

대형 언어 모델(LLM)은 많은 작업에서 놀라운 성능을 보여주는 혁신적인 도구로 등장했습니다. LLM의 크기가 커지면서, 이 모델들은 사실들을 매개변수에 저장하여 독립적으로도 매우 효과적인 지식 저장소 역할을 할 수 있게 되었습니다. 그러나 특정 작업에 필요한 도메인 지식을 충분히 포함하지 못하고, 세상이 계속 변하면서 모델에 포함된 사실이 틀릴 수 있습니다. 추가적인 미세 조정이나 편집을 통해 이러한 모델의 지식을 업데이트하는 것은 어렵습니다.

대안으로는 대량의 텍스트를 인덱싱하고, 이를 작은 조각으로 나누어 별도의 정보 검색 시스템에 저장하는 접근 방식이 있습니다. 검색된 정보는 질문과 함께 LLM에 제공되어 "검색 증강"을 통해 현재의 도메인 지식을 쉽게 제공하고 해석 가능성 및 출처 추적이 가능하게 합니다. 그러나 기존의 검색 증강 접근 방식에도 한계가 있습니다. 대부분의 기존 방법은 몇 개의 짧고 연속적인 텍스트 조각만 검색하여, 큰 규모의 담론 구조를 표현하고 활용하는 데 제한이 있습니다.

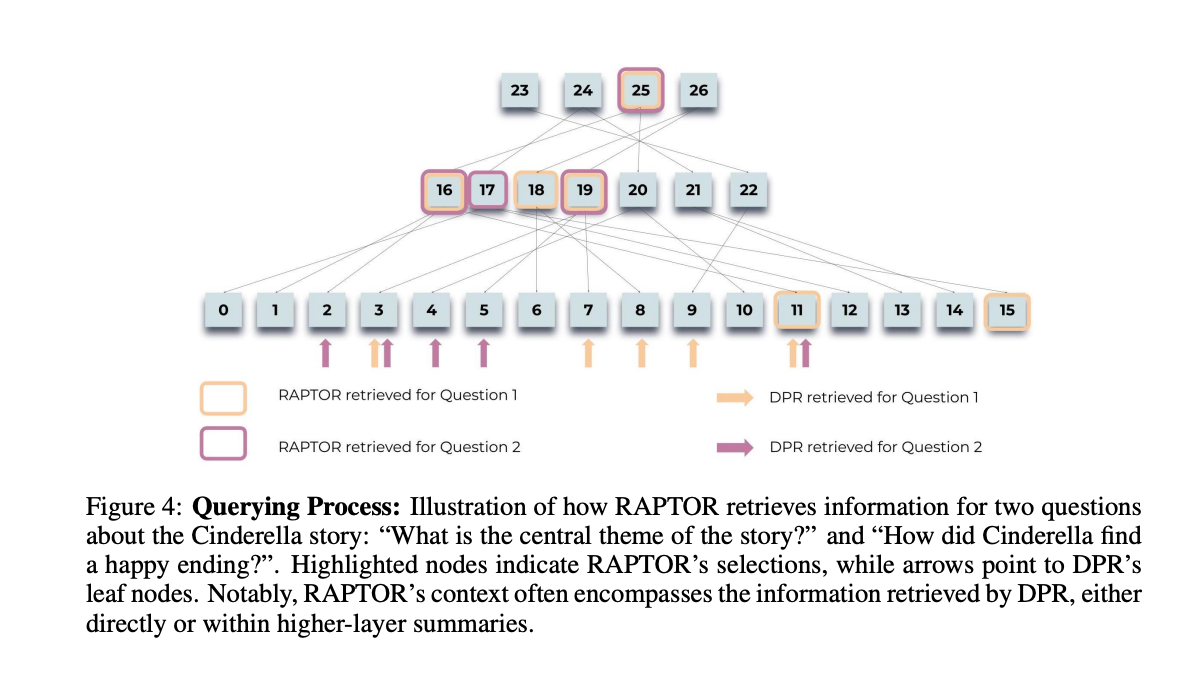

이를 해결하기 위해 텍스트의 고수준 및 저수준 세부사항을 모두 포착하는 트리 구조를 사용하는 인덱싱 및 검색 시스템을 설계했습니다. 논문에서 제안하는 시스템 RAPTOR는 텍스트 조각을 클러스터링하고, 해당 클러스터의 텍스트 요약을 생성한 다음, 반복하여 트리를 생성합니다. 이 구조는 RAPTOR가 LLM의 컨텍스트에 다양한 수준의 텍스트 조각을 로드하여 효율적으로 질문에 답할 수 있게 합니다.

해당 논문의 주요 기여 포인트는 텍스트 요약을 사용하여 다른 규모에서 컨텍스트를 검색 증강할 수 있는 아이디어입니다. 실험 결과, RAPTOR는 현재의 검색 증강 방법보다 뛰어난 성능을 보여주었습니다. 특히, RAPTOR와 GPT-4를 결합하면 세 가지 QA 작업(NarrativeQA, QASPER, QuALITY)에서 새로운 최첨단 결과를 얻을 수 있었습니다.

2 RELATED WORK

검색의 필요성: 최근 하드웨어와 알고리즘의 발전으로 모델이 처리할 수 있는 문맥 길이가 늘어났지만, 검색 시스템의 필요성은 여전히 중요합니다. 모델은 긴 문맥을 잘 활용하지 못하고, 문맥 길이가 길어질수록 성능이 떨어지는 경향이 있습니다. 또한 긴 문맥을 사용하는 것은 비용이 많이 들고 느립니다. 따라서 중요한 정보를 선택하여 사용하는 것이 여전히 중요합니다.

검색 방법: 검색 증강 언어 모델(RALM)은 여러 요소에서 개선되었습니다. 전통적인 방법인 TF-IDF와 BM25에서부터 딥러닝 기반 전략으로 발전했습니다. 최근에는 대형 언어 모델을 검색 도구로 사용하는 방법도 제안되었습니다. 연구에는 독립적으로 구절을 처리하는 Fusion-in-Decoder(FiD)와 검색된 문맥을 바탕으로 텍스트를 생성하는 RETRO 등이 포함됩니다. 또한, 검색기와 인코더-디코더 모델을 함께 미세 조정하는 Atlas, 열린 도메인 질문 답변을 위해 마스킹된 LM을 미세 조정하는 REALM, 그리고 신경 검색기를 통합한 RAG 등이 있습니다.

다양한 방법이 있지만, 모델의 검색 요소는 주로 표준 접근 방식을 따릅니다. 그러나 연속적인 분할 방식은 텍스트의 전체 의미를 포착하지 못할 수 있습니다. 기술적이거나 과학적인 문서에서 추출한 스니펫을 읽는 것은 중요한 문맥이 부족하여 읽기 어렵거나 오해를 불러일으킬 수 있습니다.

재귀적 요약: 요약 기술은 문서의 요점을 제공하여 콘텐츠에 더 집중할 수 있게 합니다. 재귀적-추상적 요약 모델은 작은 텍스트 조각을 요약하여 큰 섹션의 요약을 만듭니다. 이 방법은 넓은 주제를 포착하는 데 효과적이지만, 세부 사항을 놓칠 수 있습니다. LlamaIndex는 인접한 텍스트 조각을 요약하면서 중간 노드를 유지하여 다양한 세부 사항을 저장합니다. 그러나 인접 노드에 의존하는 이 방법은 텍스트 내의 먼 상호 의존성을 간과할 수 있습니다. RAPTOR는 이러한 문제를 해결하기 위해 멀리 떨어진 상호 의존성을 찾고 그룹화합니다.

3 METHODS

RAPTOR 개요

RAPTOR는 무엇인가요?

긴 텍스트는 종종 하위 주제와 계층적 구조를 가지고 있습니다. RAPTOR는 이러한 구조를 활용하여, 텍스트의 전체 주제를 이해하면서도 세부 사항을 잘 반영할 수 있도록 만들어졌습니다. 이는 텍스트의 순서가 아닌 의미적 유사성에 따라 노드를 그룹화하는 재귀적 트리 구조를 사용하여 이루어집니다.

RAPTOR 트리는 어떻게 만들어지나요?

1. 텍스트 분할: 먼저, 검색할 텍스트를 100개의 토큰으로 구성된 짧고 연속적인 텍스트 조각으로 나눕니다. 문장이 100 토큰을 초과하면, 문장의 중간에서 자르지 않고 다음 조각으로 넘깁니다. 이렇게 하면 각 조각 내에서 문맥적, 의미적 일관성이 유지됩니다.

2. 임베딩: 분할된 텍스트 조각들은 SBERT(다중 질문-응답 임베딩)로 임베딩됩니다. 이 텍스트 조각과 임베딩은 트리 구조의 잎 노드가 됩니다.

3. 클러스터링: 유사한 텍스트 조각을 그룹화하기 위해 클러스터링 알고리즘을 사용합니다. 이렇게 그룹화된 텍스트는 언어 모델을 통해 요약됩니다. 요약된 텍스트는 다시 임베딩되고, 이 과정이 반복되어 다층 트리 구조가 형성됩니다.

검색 방법은?

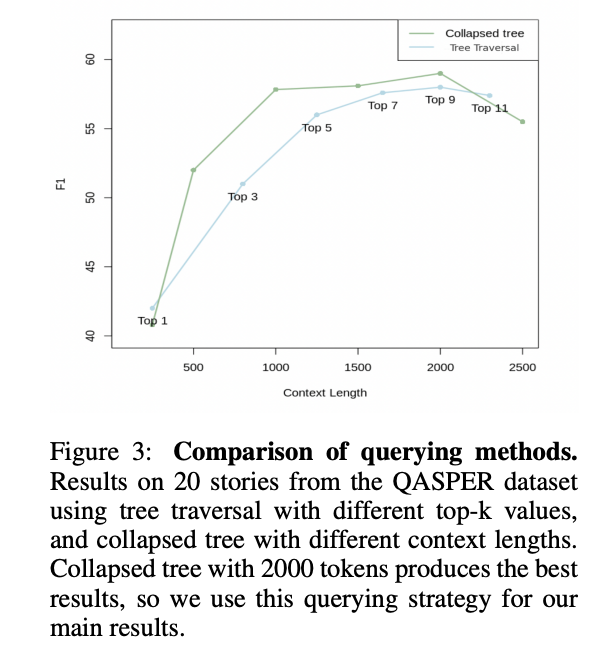

RAPTOR는 트리 내에서 정보를 검색하기 위해 두 가지 방법을 사용합니다. 트리 탐색(Tree Traversal)과 콜랩스드 트리(Collapsed Tree)입니다.

1. 트리 탐색: 트리의 각 층을 하나씩 내려가며 가장 관련성이 높은 노드를 선택합니다. 선택된 노드의 자식 노드를 다음 층에서 고려하고, 이 과정을 반복하여 잎 노드에 도달합니다. 선택된 모든 노드의 텍스트를 결합하여 검색된 컨텍스트를 형성합니다.

2. 콜랩스드 트리: 트리의 모든 노드를 한 층으로 평면화하여 한 번에 비교합니다. 쿼리와 가장 높은 코사인 유사성을 가진 상위 k개의 노드를 선택하여 검색된 정보를 형성합니다. 이 방법은 유연성이 더 크고 성능이 더 뛰어납니다.

클러스터링 알고리즘

RAPTOR의 클러스터링 알고리즘은 Gaussian Mixture Models(GMM)을 기반으로 합니다. 이 방법은 유연성을 제공하며, 노드가 여러 클러스터에 속할 수 있게 합니다. GMM은 여러 개의 가우시안 분포에서 데이터 포인트가 생성된다고 가정합니다. 클러스터 수를 최적화하기 위해 Bayesian Information Criterion(BIC)을 사용합니다.

요약 및 질의

클러스터링된 노드는 언어 모델을 통해 요약됩니다. RAPTOR는 gpt-3.5-turbo를 사용하여 요약을 생성합니다. 질의 방법으로는 트리 탐색과 콜랩스드 트리 방법이 사용됩니다. 콜랩스드 트리 접근법이 더 나은 성능을 보이므로 주로 사용됩니다.

4 EXPERIMENTS

데이터셋

RAPTOR는 세 가지 질문-답변(QA) 데이터셋에서 성능이 평가되었습니다. NarrativeQA, QASPER, 그리고 QuALITY입니다.

1. NarrativeQA: 책과 영화 대본의 전체 텍스트를 바탕으로 질문-답변 쌍을 포함한 데이터셋입니다. 총 1,572개의 문서가 포함되어 있으며, 모델이 긴 문학 텍스트를 얼마나 잘 이해하는지를 평가합니다. 성능 평가는 BLEU, ROUGE, METEOR 지표로 측정됩니다.

2. QASPER: 1,585개의 NLP 논문에서 5,049개의 질문을 포함한 데이터셋입니다. 질문은 논문의 전체 텍스트에 내포된 정보를 찾기 위해 구성되어 있으며, 정답률은 표준 F1 점수로 측정됩니다.

3. QuALITY: 약 5,000개의 토큰 길이의 문맥 구절과 함께 다중 선택 질문을 포함한 데이터셋입니다. 이 데이터셋은 중간 길이의 문서를 바탕으로 한 추론을 요구하며, 특히 사람들이 대부분 오답을 기록한 어려운 질문이 포함된 QuALITY-HARD도 있습니다. 성능은 정확도로 측정됩니다.

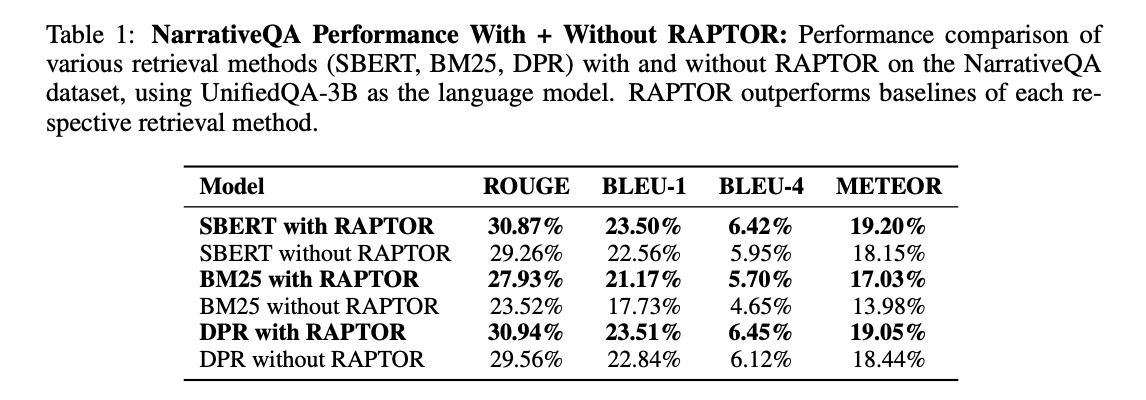

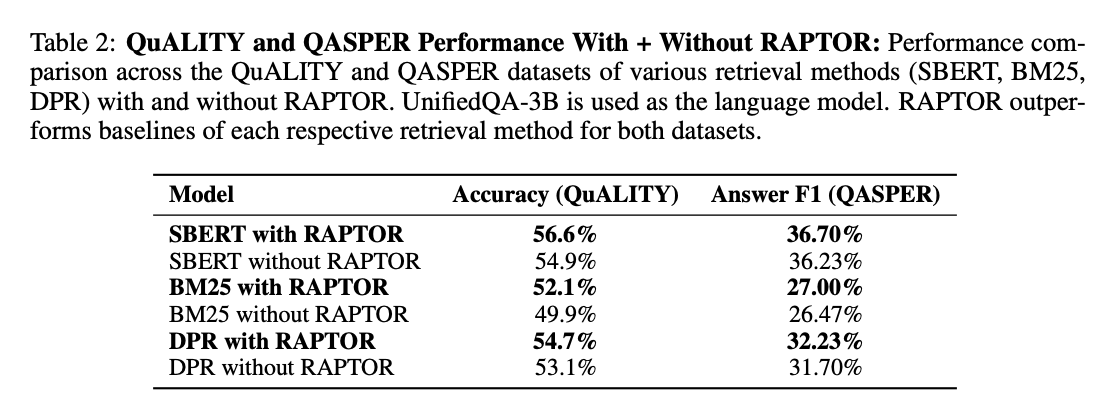

베이스 모델과의 비교

RAPTOR의 성능을 평가하기 위해, SBERT, BM25, DPR 등의 임베딩 모델과 결합한 경우와 결합하지 않은 경우를 비교했습니다. 그 결과, RAPTOR는 각 데이터셋에서 해당 모델들을 결합했을 때 일관되게 더 나은 성능을 보였습니다.

- NarrativeQA: RAPTOR는 SBERT와 결합했을 때 ROUGE, BLEU, METEOR 지표 모두에서 성능이 향상되었습니다.

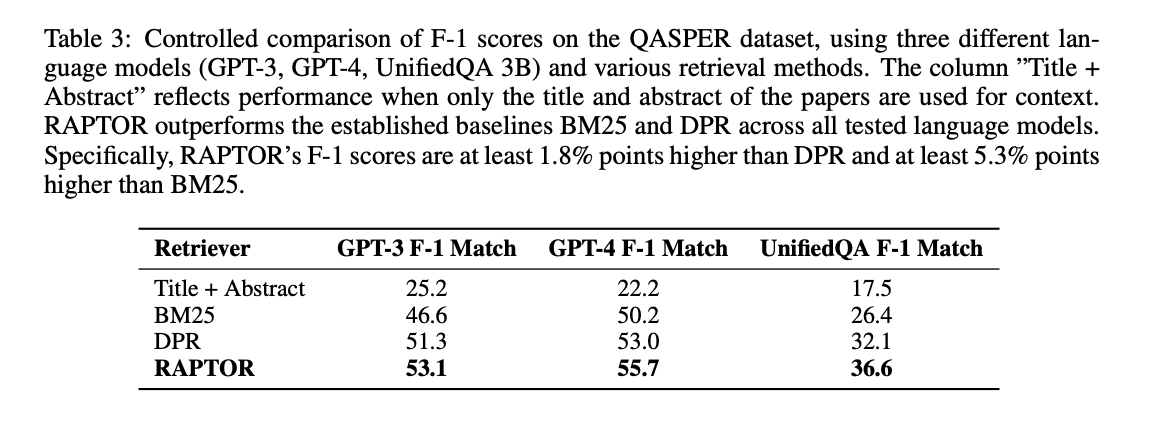

- QASPER: RAPTOR는 GPT-3, GPT-4, UnifiedQA와 결합했을 때 F1 점수가 각각 53.1%, 55.7%, 36.6%로, DPR과 BM25보다 더 나은 성능을 보였습니다.

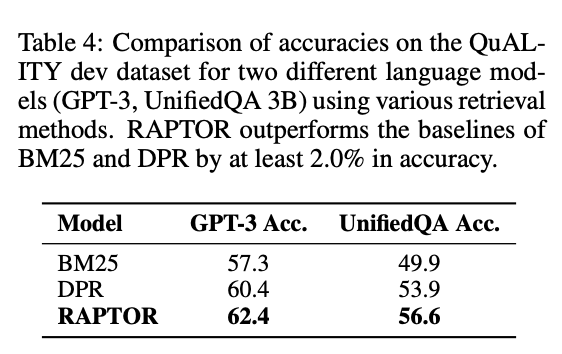

- QuALITY: RAPTOR는 정확도에서 DPR과 BM25보다 더 높은 성능을 보였습니다.

SOTA 기술과의 비교

RAPTOR는 SOTA 모델들과 비교했을 때도 뛰어난 성능을 보였습니다.

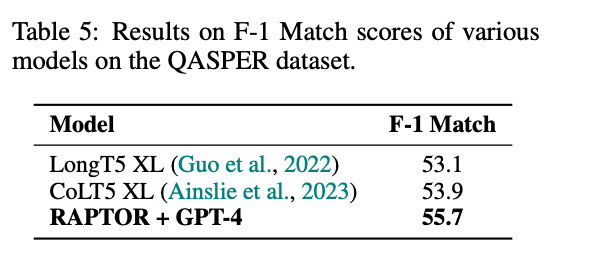

- QASPER: GPT-4와 결합했을 때 55.7%의 F1 점수로, 이전의 최고 점수인 53.9%를 초과했습니다.

- QuALITY: GPT-4와 결합했을 때 82.6%의 정확도로, 이전 최고 결과인 62.3%를 크게 초과했습니다.

- NarrativeQA: UnifiedQA와 결합했을 때 METEOR 점수에서 새로운 최고 기록을 세웠습니다.

4.1 CONTRIBUTION OF THE TREE STRUCTURE

RAPTOR의 트리 구조가 어떻게 도움이 될까?

논문에서는 각 노드 계층이 RAPTOR의 검색 기능에 얼마나 기여하는지 분석했습니다. 상위 노드들이 주제나 여러 단계를 거치는 질문(다중 홉 질문)을 다루는 데 중요한 역할을 한다고 가정했습니다.

NarrativeQA 데이터셋에서의 성능 비교

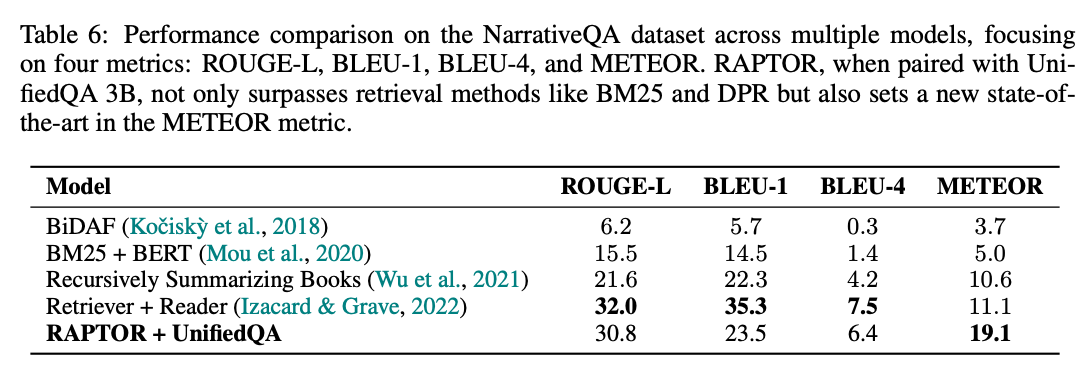

RAPTOR가 다양한 모델과 비교했을 때 성능이 어떻게 되는지 살펴보았습니다. 네 가지 지표(ROUGE-L, BLEU-1, BLEU-4, METEOR)를 사용하여 평가했습니다. RAPTOR는 UnifiedQA 3B와 결합했을 때, BM25와 DPR 같은 기존의 검색 방법을 능가했으며, METEOR 지표에서 새로운 최고 성능을 기록했습니다.

QuALITY 데이터셋에서의 성능

전체 테스트 세트와 더 어려운 하위 세트에서의 정확도를 비교했습니다. GPT-4와 결합된 RAPTOR는 새로운 최고 성능을 기록했습니다.

- 전체 테스트 세트 정확도: 82.6%

- 어려운 하위 세트 정확도: 76.2%

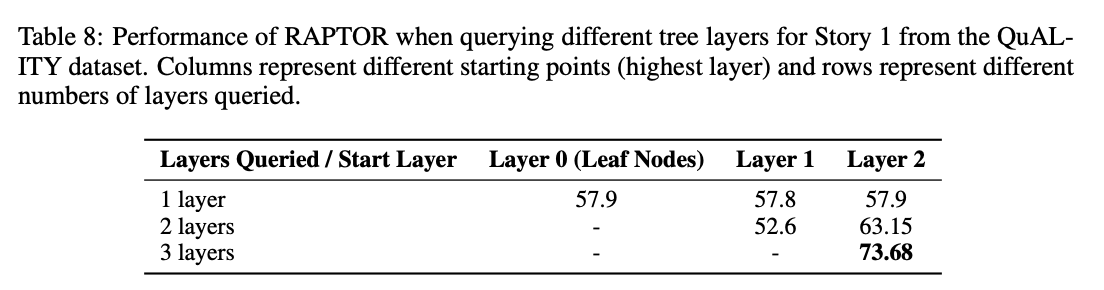

다양한 계층을 검색할 때의 성능 비교

트리의 각 계층이 얼마나 중요한지 확인하기 위해, QuALITY 데이터셋의 스토리를 사용하여 실험을 했습니다. RAPTOR 트리는 각 스토리에 대해 구축되었고, 검색할 때는 다른 계층의 부분 집합으로 제한했습니다. 예를 들어, 리프 노드(가장 아래 노드)와 각 상위 계층에서만 검색하거나, 여러 계층을 연속적으로 검색하는 방법을 사용했습니다.

한 스토리에서의 결과를 표로 정리했습니다. 결과는 전체 트리 검색, 즉 모든 계층을 활용한 검색이 특정 계층에만 초점을 맞춘 검색 전략보다 더 나은 성능을 보였음을 나타냅니다.

이 결과는 RAPTOR의 전체 트리 구조의 중요성을 강조합니다. 원본 텍스트와 상위 요약을 모두 제공함으로써, RAPTOR는 더 넓은 범위의 질문을 효과적으로 처리할 수 있습니다. 주제 관련 높은 질문부터 세부 사항에 초점을 맞춘 질문까지 모두 잘 처리할 수 있습니다.

5 CONCLUSION

이 논문에서는 RAPTOR라는 새로운 트리 기반 검색 시스템을 소개했습니다. RAPTOR는 대형 언어 모델의 지식을 다양한 추상화 수준에서의 문맥 정보로 보강합니다. 재귀적인 클러스터링과 요약 기술을 사용하여, RAPTOR는 검색 코퍼스의 여러 섹션에 걸쳐 정보를 종합할 수 있는 계층적 트리 구조를 만듭니다. 질의 단계에서는 이 트리 구조를 활용하여 더 효과적인 검색을 수행합니다. 통제된 실험 결과, RAPTOR는 전통적인 검색 방법을 능가할 뿐만 아니라, 여러 질문-답변 작업에서 새로운 성능 기준을 세웠습니다.

댓글